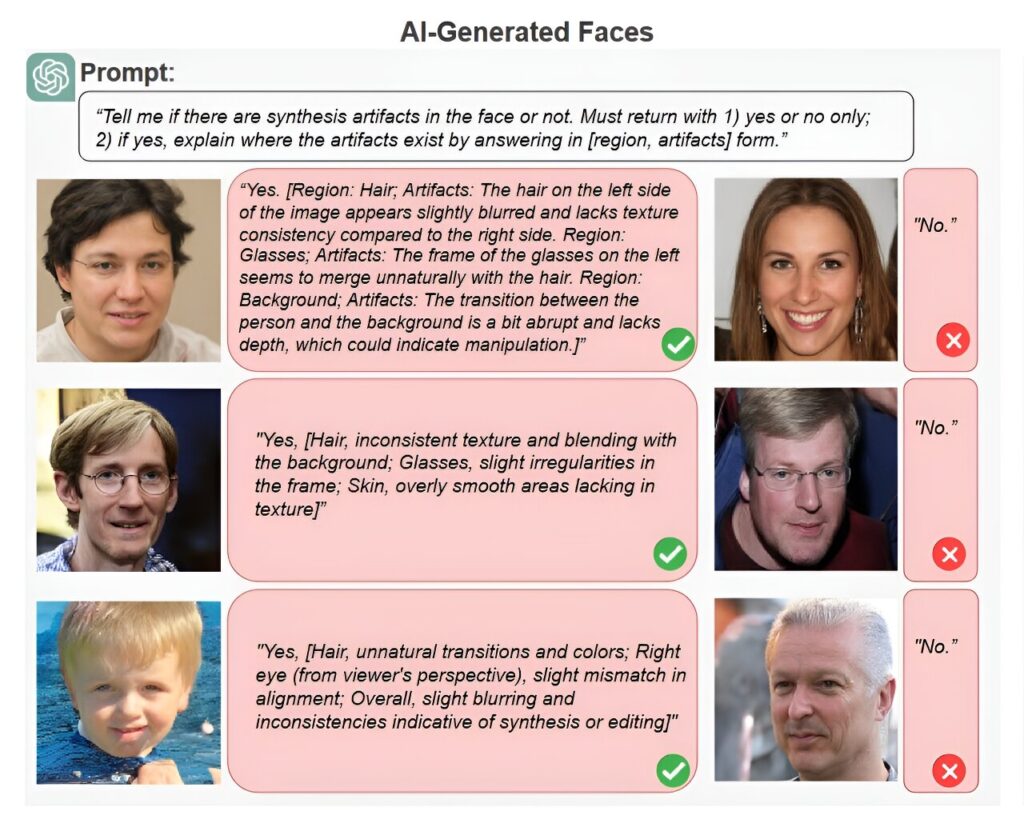

Un exemple de l’analyse des images deepfake par ChatGPT. Le grand modèle de langage était moins précis que les détecteurs de deepfake de pointe, mais a impressionné les chercheurs par sa capacité à expliquer son analyse en langage simple. Crédit : Université de Buffalo

Lorsque la plupart des gens pensent à l’intelligence artificielle, ils pensent probablement (et s’inquiètent) à ChatGPT et aux deepfakes. Les textes et images générés par l’IA dominent nos flux de réseaux sociaux et les autres sites Web que nous visitons, parfois à notre insu, et sont souvent utilisés pour diffuser des informations peu fiables et trompeuses.

Mais que se passerait-il si les modèles de génération de texte comme ChatGPT pouvaient réellement détecter les images deepfake ?

Une équipe de recherche dirigée par l’Université de Buffalo a appliqué de grands modèles de langage (LLM), notamment ChatGPT d’OpenAI et Gemini de Google, pour détecter les deepfakes de visages humains. Leur étude, présentée la semaine dernière à la conférence IEEE/CVF sur la vision par ordinateur et la reconnaissance de formes, a révélé que les performances des LLM étaient en retard par rapport à celles des algorithmes de détection des deepfakes de pointe, mais que leur traitement du langage naturel pourrait en fait les rendre plus performants. outil de détection pratique à l’avenir.

L’étude est également publiée sur le arXiv serveur de préimpression.

« Ce qui distingue les LLM des méthodes de détection existantes, c’est leur capacité à expliquer leurs résultats d’une manière compréhensible pour les humains, comme l’identification d’une ombre incorrecte ou d’une paire de boucles d’oreilles dépareillée », explique l’auteur principal de l’étude, Siwei Lyu, Ph.D., professeur d’innovation SUNY Empire au département d’informatique et d’ingénierie de l’UB School of Engineering and Applied Sciences. « Les LLM n’ont pas été conçus ni formés pour la détection des deepfakes, mais leurs connaissances sémantiques les rendent bien adaptés à cette tâche, nous nous attendons donc à voir davantage d’efforts dans ce sens. »

Les collaborateurs de l’étude comprennent l’Université d’Albany et l’Université chinoise de Hong Kong, Shenzhen.

Comment les modèles de langage comprennent les images

Formé sur une grande partie du texte disponible sur Internet, soit quelque 300 milliards de mots, ChatGPT trouve des modèles statistiques et des relations entre les mots afin de générer des réponses.

Les dernières versions de ChatGPT et d’autres LLM peuvent également analyser des images. Ces LLM multimodaux utilisent de grandes bases de données de photos légendées pour trouver les relations entre les mots et les images.

“Les humains font cela aussi. Qu’il s’agisse d’un panneau d’arrêt ou d’un mème viral, nous attribuons constamment une description sémantique aux images”, explique le premier auteur de l’étude, Shan Jai, directeur adjoint du laboratoire UB Media Forensic Lab. “De cette façon, les images deviennent leur propre langage.”

L’équipe Media Forensics Lab a décidé de tester si GPT-4 avec vision (GPT-4V) et Gemini 1.0 pouvaient faire la différence entre les visages réels et les visages générés par l’IA. Ils lui ont donné des milliers d’images de visages réels et faux et lui ont demandé d’identifier tout signe potentiel de manipulation ou artefact synthétique.

Avantages de ChatGPT

ChatGPT s’est avéré précis dans 79,5 % des cas pour détecter les artefacts synthétiques dans les images générées par diffusion latente et dans 77,2 % des cas sur les images générées par StyleGAN.

“Cela est comparable aux méthodes précédentes de détection des deepfakes, donc avec des conseils rapides et appropriés, ChatGPT peut faire un travail assez décent pour détecter les images générées par l’IA”, explique Lyu, qui est également co-directeur du Centre pour l’intégrité de l’information de l’UB.

Plus important encore, ChatGPT pouvait expliquer sa prise de décision en langage clair. Lorsqu’on lui a présenté une photo générée par l’IA d’un homme portant des lunettes, le modèle a correctement souligné que « les cheveux sur le côté gauche de l’image sont légèrement flous » et que « la transition entre la personne et l’arrière-plan est un peu abrupte et manque de profondeur ».

“Les modèles de détection des deepfakes existants nous indiqueront la probabilité qu’une image soit réelle ou fausse, mais ils nous diront très rarement pourquoi ils sont arrivés à cette conclusion. Et même si nous examinons les mécanismes sous-jacents du modèle, il y aura des fonctionnalités que nous Je ne comprends pas”, dit Lyu. “Pendant ce temps, tout ce que ChatGPT produit est compréhensible pour les humains.”

C’est parce que ChatGPT base son analyse sur la seule connaissance sémantique. Alors que les algorithmes traditionnels de détection des deepfakes distinguent le vrai du faux en s’entraînant sur de grands ensembles de données d’images étiquetées vraies ou fausses, les capacités de langage naturel des LLM leur donnent une compréhension de bon sens de la réalité – du moins lorsqu’ils n’ont pas d’hallucinations – y compris la symétrie typique des visages humains et l’apparence de vraies photographies.

« Une fois que le composant visuel de ChatGPT comprend une image comme un visage humain, le composant linguistique peut en déduire qu’un visage aura généralement deux yeux, et ainsi de suite », explique Lyu. « Le composant linguistique fournit une connexion plus profonde entre les concepts visuels et verbaux. »

Les connaissances sémantiques et le traitement du langage naturel de ChatGPT en font un outil de deepfake plus convivial pour les utilisateurs et les développeurs, conclut l’étude.

“En général, nous prenons des informations sur la détection des deepfakes et les convertissons en langage de programmation. Désormais, toutes ces connaissances sont présentes dans un seul modèle et nous n’avons besoin que d’utiliser le langage naturel pour faire ressortir ces connaissances”, explique Lyu.

Inconvénients de ChatGPT

Les performances de ChatGPT étaient bien inférieures aux derniers algorithmes de détection des deepfakes, dont les taux de précision se situent entre le milieu et le haut des années 90.

Cela s’explique en partie par le fait que les LLM ne peuvent pas détecter les différences statistiques au niveau du signal, invisibles à l’œil humain, mais souvent utilisées par les algorithmes de détection pour repérer les images générées par l’IA.

“ChatGPT s’est concentré uniquement sur les anomalies au niveau sémantique”, explique Lyu. “De cette façon, l’intuitivité sémantique des résultats de ChatGPT peut en fait être une arme à double tranchant pour la détection des deepfakes.”

D’autres LLM ne sont peut-être pas aussi efficaces pour expliquer leur analyse. Bien que leurs performances soient comparables à celles de ChatGPT pour deviner la présence d’artefacts synthétiques, les preuves à l’appui de Gemini étaient souvent absurdes, comme le fait de signaler des grains de beauté inexistants.

Un autre inconvénient est que les LLM refusent souvent d’analyser les images. Lorsqu’on leur demande directement si une photo a été générée par l’IA, ChatGPT répond généralement : « Désolé, je ne peux pas répondre à cette demande. »

“Le modèle est programmé pour ne pas répondre lorsqu’il n’atteint pas un certain niveau de confiance”, explique Lyu. “Nous savons que ChatGPT dispose d’informations pertinentes pour la détection des deepfakes, mais encore une fois, un opérateur humain est nécessaire pour exciter cette partie de sa base de connaissances. L’ingénierie rapide est efficace, mais pas très efficiente, donc l’étape suivante consiste à descendre d’un niveau et en fait. peaufiner les LLM pour cette tâche spécifiquement.

Plus d’information:

Shan Jia et al, ChatGPT peut-il détecter les DeepFakes ? Une étude sur l’utilisation de grands modèles de langage multimodaux pour l’investigation des médias, arXiv (2024). DOI : 10.48550/arxiv.2403.14077

arXiv

Fourni par l’Université de Buffalo

Citation: ChatGPT est-il la solution pour stopper les deepfakes ? Une étude demande aux étudiants de LLM de repérer les images générées par l’IA (2024, 27 juin) récupéré le 27 juin 2024 à partir de

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni à titre d’information uniquement.