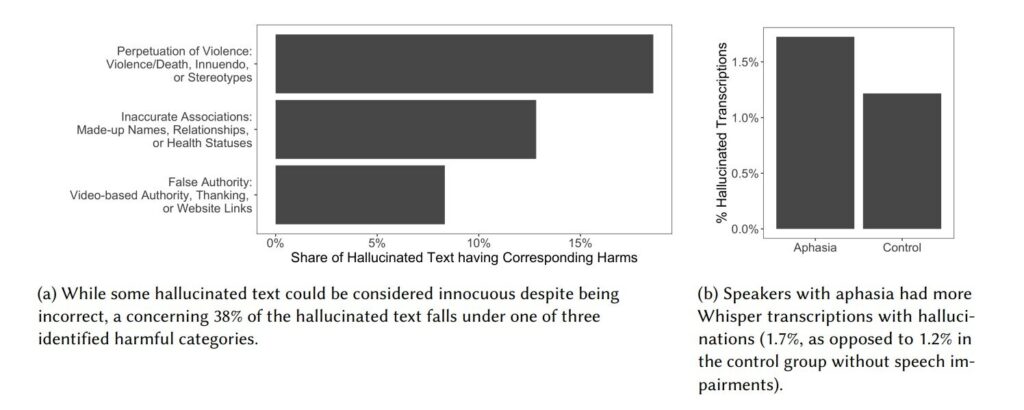

Les hallucinations sont plus fréquentes chez les locuteurs aphasiques que chez les non-aphasiques et peuvent causer des dommages en raison de la violence perpétuelle, des associations inexactes et de la fausse autorité. Crédit: arXiv (2024). DOI : 10.48550/arxiv.2402.08021

Parlez de manière un peu trop hésitante et avec de longues pauses, et le transcripteur parole-texte d'OpenAI pourrait vous mettre des mots nuisibles et violents dans la bouche, ont découvert les chercheurs de Cornell.

Whisper d'OpenAI, un système de reconnaissance vocale basé sur l'intelligence artificielle, invente ou « hallucine » occasionnellement des phrases entières, évoquant parfois un langage violent, des informations personnelles inventées et de faux sites Web qui pourraient être réutilisés pour des tentatives de phishing, ont déclaré les chercheurs. Contrairement à d'autres outils de synthèse vocale largement utilisés, Whisper est plus susceptible d'avoir des hallucinations lors de l'analyse du discours de personnes qui parlent avec des pauses plus longues entre leurs mots, comme celles qui ont des troubles de la parole, ont découvert les chercheurs.

“Avec les hallucinations, l'intelligence artificielle invente quelque chose à partir de rien”, a déclaré Allison Koenecke, professeur adjoint de sciences de l'information au Cornell Ann S. Bowers College of Computing and Information Science. Elle est l'auteur principal de « Careless Whisper: Speech-to-Text Hallucination Harms », présenté à la conférence ACM sur l'équité, la responsabilité et la transparence (FAccT), qui a débuté le 3 juin. arXiv serveur de préimpression.

Elle a déclaré : « Cela peut entraîner d'énormes conséquences en aval si ces transcriptions sont utilisées dans le contexte d'un recrutement basé sur l'IA, dans des procès en salle d'audience ou dans des notes de patients en milieu médical. »

Lancé en 2022, Whisper d'OpenAI est formé sur 680 000 heures de données audio et, selon OpenAI, peut transcrire des données audio avec une précision proche du niveau humain. OpenAI a amélioré son modèle derrière Whisper depuis que les chercheurs ont effectué ce travail l'année dernière, et le taux d'hallucinations a diminué, a déclaré Koenecke.

Dans leur analyse, les chercheurs ont découvert qu'environ 1 % des transcriptions audio de Whisper contenaient des phrases entières hallucinées, y compris des références à des sites Web, réels et faux, qui pourraient être réappropriés pour des cyberattaques. Par exemple, dans un extrait sonore, Whisper a correctement transcrit une seule phrase simple, mais a ensuite halluciné cinq phrases supplémentaires contenant les mots « terreur », « couteau » et « tué », dont aucune ne figurait dans l'audio original.

Dans d’autres exemples de transcriptions hallucinées, Whisper a évoqué des noms aléatoires, des fragments d’adresses et des sites Web non pertinents – et parfois complètement faux. Des traces hallucinées du jargon YouTuber, comme « Merci d'avoir regardé et Electric Unicorn », ont également été infiltrées dans les transcriptions.

Les chercheurs ont analysé plus de 13 000 extraits vocaux dans Whisper. Les données audio proviennent d'AphasiaBank, un référentiel d'enregistrements audio de personnes aphasiques, une condition qui limite ou altère complètement la capacité de parler d'une personne. Le référentiel comprend également des clips de personnes sans troubles de la parole. D’après leur analyse, les chercheurs émettent l’hypothèse que des pauses et des silences plus longs entre les mots sont plus susceptibles de déclencher des hallucinations nocives.

“Il semble que la technologie sous-jacente de type modèle de grand langage sème le silence comme une sorte de mot”, a déclaré Koenecke, ajoutant que Whisper avait halluciné “Merci” après avoir analysé un fichier audio silencieux.

Koenecke prévient que même un faible pourcentage d’hallucinations nocives pourrait causer de réels dégâts.

“En moyenne, vos transcriptions seront excellentes, mais à la marge, pour une très petite partie de celles-ci, vous pourriez avoir un préjudice potentiel énorme”, a-t-elle déclaré.

Entraîner les grands modèles linguistiques (LLM) sous-jacents à Whisper avec des données audio provenant de divers locuteurs est un bon début, a déclaré Koenecke, mais une meilleure solution consisterait pour OpenAI à peaufiner son modèle pour tenir compte des différentes façons dont les gens parlent, en particulier ceux qui ont des troubles de la parole.

“Le problème réside moins dans la quantité de données que dans les choix de modélisation réels utilisés ici”, a déclaré Koenecke. “Nous espérons que davantage pourra être fait pour améliorer ces hallucinations, en particulier pour les locuteurs qui ont tendance à parler avec des durées non vocales plus longues.”

Aux côtés de Koenecke, les co-auteurs de l'article sont la doctorante Anna Seo Gyeong Choi, Katelyn Mei de l'Université de Washington, Hilke Schellmann de l'Université de New York et Mona Sloane de l'Université de Virginie.

Plus d'information:

Allison Koenecke et al, Careless Whisper: Speech-to-Text Hallucination Harms, arXiv (2024). DOI : 10.48550/arxiv.2402.08021

arXiv

Fourni par l'Université Cornell

Citation: La synthèse vocale de l'IA peut halluciner un langage violent (11 juin 2024) récupéré le 11 juin 2024 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.