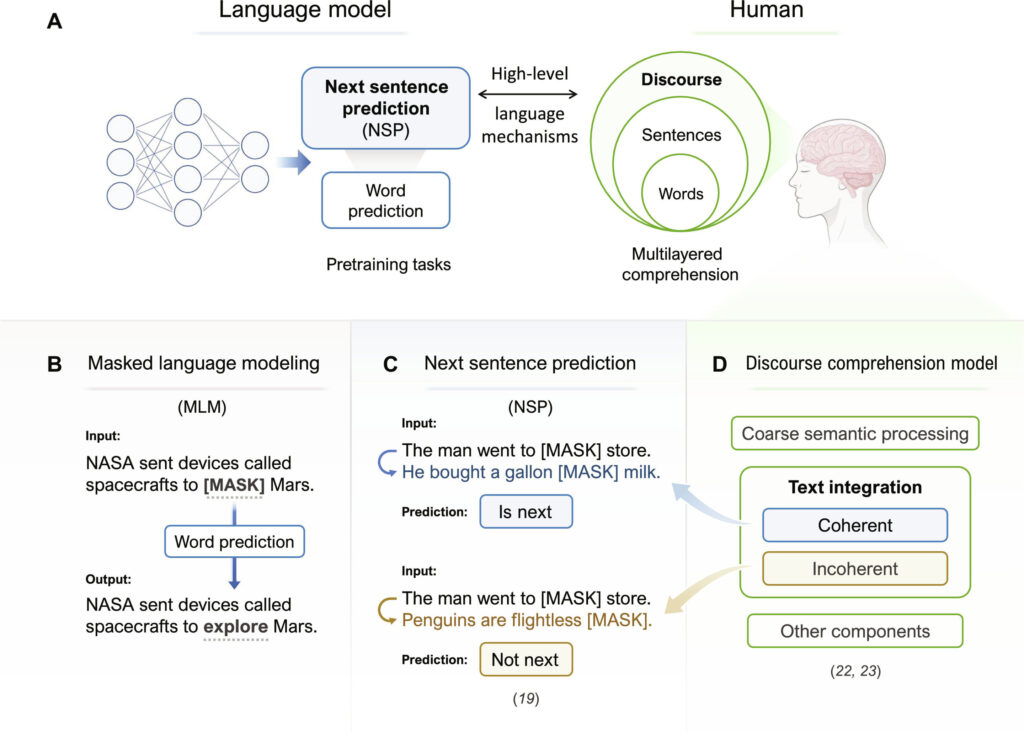

NSP comme compte rendu informatique de la compréhension du discours. (A) Les humains intègrent des mots et des phrases pour parvenir à une compréhension complète du discours. Dans les LLM, la tâche NSP proposée par BERT peut servir de compte rendu informatique de la compréhension du discours humain. (B) Illustration de la tâche MLM. (C) Illustration de la tâche NSP et de sa pertinence par rapport au modèle Mason et Just. (D) Illustration du modèle neurocognitif de traitement du discours de Mason et Just. Crédit: Avancées scientifiques (2024). DOI : 10.1126/sciadv.adn7744

Alors que l’intelligence artificielle générative (GenAI) a transformé le paysage des interactions sociales ces dernières années, les grands modèles de langage (LLM), qui utilisent des algorithmes d’apprentissage en profondeur pour entraîner les plateformes GenAI à traiter le langage, ont été mis sous les projecteurs.

Une étude récente de l'Université polytechnique de Hong Kong (PolyU) a révélé que les LLM fonctionnent davantage comme le cerveau humain lorsqu'ils sont formés de manière plus similaire à celle des humains qui traitent le langage, ce qui a apporté des informations importantes aux études sur le cerveau et au développement de modèles d'IA.

Les LLM actuels reposent principalement sur un seul type de pré-formation : la prédiction contextuelle de mots. Cette stratégie d'apprentissage simple a obtenu un succès surprenant lorsqu'elle est combinée à des données de formation massives et à des paramètres de modèle, comme le montrent des LLM populaires tels que ChatGPT.

Des études récentes suggèrent également que la prédiction de mots dans les LLM peut servir de modèle plausible sur la façon dont les humains traitent le langage. Cependant, les humains ne se contentent pas de prédire le mot suivant, mais intègrent également des informations de haut niveau dans la compréhension du langage naturel.

Une équipe de recherche dirigée par le professeur Li Ping, doyen de la Faculté des sciences humaines et professeur de la Fondation Sin Wai Kin en sciences humaines et technologies à PolyU, a étudié la prochaine tâche de prédiction de phrase (NSP), qui simule un processus central de compréhension au niveau du discours. dans le cerveau humain pour évaluer si une paire de phrases est cohérente, dans le pré-entraînement du modèle et a examiné la corrélation entre les données du modèle et l'activation cérébrale.

L'étude a été récemment publiée dans la revue Avancées scientifiques.

L'équipe de recherche a formé deux modèles, l'un avec amélioration NSP et l'autre sans ; tous deux ont également appris la prédiction de mots. Des données d'imagerie par résonance magnétique fonctionnelle (IRMf) ont été collectées auprès de personnes lisant des phrases connectées ou des phrases déconnectées. L’équipe de recherche a examiné dans quelle mesure les schémas de chaque modèle correspondaient aux schémas cérébraux des données cérébrales IRMf.

Il était clair que la formation avec NSP présentait des avantages. Le modèle avec NSP correspondait bien mieux à l’activité du cerveau humain dans plusieurs domaines que le modèle formé uniquement sur la prédiction de mots. Son mécanisme correspond également parfaitement aux modèles neuronaux établis de compréhension du discours humain.

Les résultats donnent de nouvelles informations sur la façon dont notre cerveau traite l’intégralité du discours, comme les conversations. Par exemple, des parties du côté droit du cerveau, et pas seulement du côté gauche, aidaient à comprendre un discours plus long. Le modèle formé avec NSP pourrait également mieux prédire la vitesse à laquelle quelqu'un lit, démontrant que la simulation de la compréhension du discours via NSP a aidé l'IA à mieux comprendre les humains.

Les LLM récents, y compris ChatGPT, se sont appuyés sur une augmentation considérable des données de formation et de la taille du modèle pour obtenir de meilleures performances. Le professeur Li Ping a déclaré : « Il y a des limites à s'appuyer uniquement sur une telle mise à l'échelle. Les progrès devraient également viser à rendre les modèles plus efficaces, en s'appuyant sur moins de données plutôt que sur plus. Nos résultats suggèrent que diverses tâches d'apprentissage telles que NSP peuvent améliorer les LLM. être plus humain et potentiellement plus proche de l'intelligence humaine.

“Plus important encore, les résultats montrent comment les chercheurs en neurocognition peuvent exploiter les LLM pour étudier les mécanismes linguistiques de plus haut niveau de notre cerveau. Ils favorisent également l'interaction et la collaboration entre les chercheurs dans les domaines de l'IA et de la neurocognition, ce qui mènera à de futures études sur les connaissances basées sur l'IA. études sur le cerveau ainsi que l'IA inspirée du cerveau.

Plus d'information:

Shaoyun Yu et al, Prédire la phrase suivante (pas le mot) dans de grands modèles linguistiques : ce que l'alignement modèle-cerveau nous dit sur la compréhension du discours, Avancées scientifiques (2024). DOI : 10.1126/sciadv.adn7744

Fourni par l'Université polytechnique de Hong Kong

Citation: L'amélioration des grands modèles de langage de l'IA les aide à mieux s'aligner sur l'activité cérébrale humaine (27 mai 2024) récupéré le 27 mai 2024 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.