Des chercheurs du MIT ont étudié les performances des étudiants en master dans différentes tâches, mettant à l’épreuve leurs capacités de mémorisation et de raisonnement. Résultat : leurs capacités de raisonnement sont souvent surestimées. Crédit : Alex Shipps/MIT CSAIL

En matière d’intelligence artificielle, les apparences peuvent être trompeuses. Le mystère qui entoure le fonctionnement interne des grands modèles linguistiques (LLM) tient à leur taille gigantesque, à leurs méthodes d’apprentissage complexes, à leurs comportements difficiles à prévoir et à leur interprétabilité difficile.

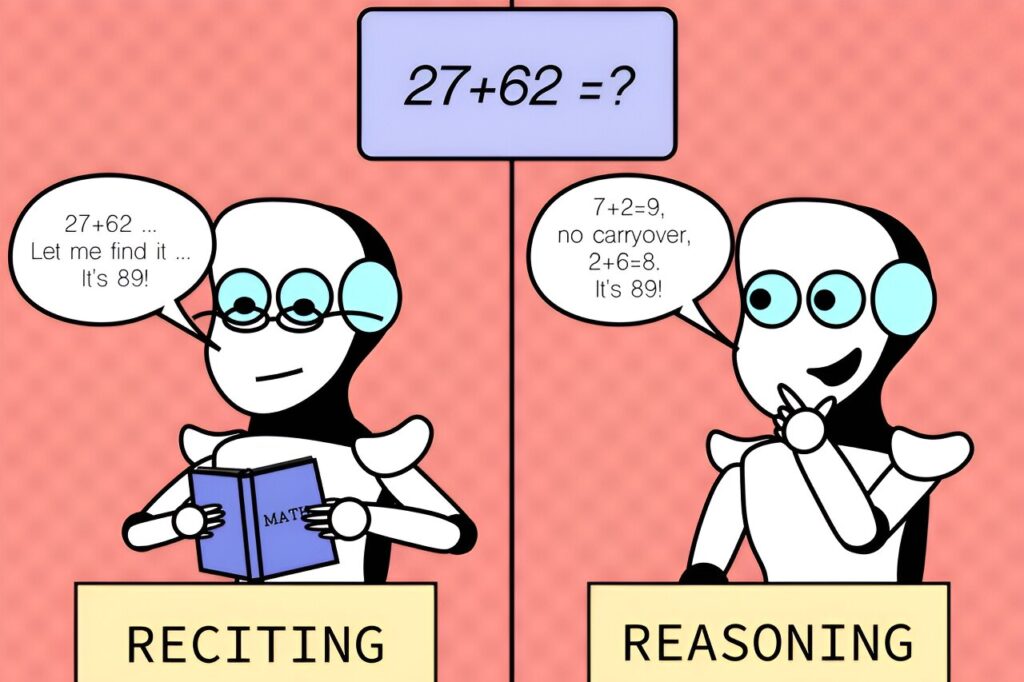

Les chercheurs du laboratoire d’informatique et d’intelligence artificielle (CSAIL) du MIT ont récemment examiné la façon dont les LLM s’en sortent avec différentes tâches, révélant des informations fascinantes sur l’interaction entre la mémorisation et les capacités de raisonnement. Il s’avère que leurs capacités de raisonnement sont souvent surestimées.

La recherche est publiée sur le arXiv serveur de préimpression.

L’étude a comparé les « tâches par défaut », les tâches courantes sur lesquelles un modèle est formé et testé, avec des « scénarios contrefactuels », des situations hypothétiques s’écartant des conditions par défaut, auxquelles des modèles comme GPT-4 et Claude sont généralement censés faire face. Les chercheurs ont développé certains tests en dehors des zones de confort des modèles en modifiant les tâches existantes au lieu d’en créer de nouvelles. Ils ont utilisé une variété d’ensembles de données et de repères spécifiquement adaptés à différents aspects des capacités des modèles pour des choses comme l’arithmétique, les échecs, l’évaluation de code, la réponse à des questions logiques, etc.

Lorsque les utilisateurs interagissent avec des modèles de langage, toute opération arithmétique est généralement effectuée en base 10, la base numérique familière aux modèles. Mais le fait de constater qu’ils réussissent bien en base 10 pourrait nous donner l’impression erronée qu’ils ont de bonnes compétences en addition. Logiquement, s’ils possèdent vraiment de bonnes compétences en addition, on s’attendrait à ce qu’ils aient des performances élevées et fiables dans toutes les bases numériques, à l’instar des calculatrices ou des ordinateurs.

En effet, les recherches ont montré que ces modèles ne sont pas aussi robustes que beaucoup le pensent au départ. Leurs performances élevées se limitent aux variantes de tâches courantes et souffrent d’une baisse de performance constante et sévère dans les scénarios contrefactuels inconnus, ce qui indique un manque de capacité d’addition généralisable.

Ce modèle s’est avéré valable pour de nombreuses autres tâches comme le doigté des accords musicaux, le raisonnement spatial et même les problèmes d’échecs où les positions de départ des pièces étaient légèrement modifiées. Alors que les joueurs humains sont censés être toujours capables de déterminer la légalité des mouvements dans des scénarios modifiés (en leur laissant suffisamment de temps), les modèles ont eu du mal et n’ont pas pu faire mieux que de deviner au hasard, ce qui signifie qu’ils ont une capacité limitée à généraliser à des situations inconnues. Et une grande partie de leurs performances sur les tâches standard ne sont probablement pas dues à des capacités générales, mais à un surajustement ou à une mémorisation directe de ce qu’ils ont vu dans leurs données d’entraînement.

« Nous avons découvert un aspect fascinant des grands modèles de langage : ils excellent dans des scénarios familiers, presque comme sur un chemin bien tracé, mais ont du mal lorsque le terrain devient inconnu. Cette idée est cruciale alors que nous nous efforçons d’améliorer l’adaptabilité de ces modèles et d’élargir leurs horizons d’application », explique Zhaofeng Wu, doctorant au MIT en génie électrique et informatique, affilié au CSAIL, et auteur principal du nouvel article.

« L’IA étant de plus en plus omniprésente dans notre société, elle doit gérer de manière fiable divers scénarios, qu’ils soient familiers ou non. Nous espérons que ces connaissances éclaireront un jour la conception des futurs LLM avec une robustesse améliorée. »

Malgré les informations obtenues, il existe bien sûr des limites. L’étude s’est concentrée sur des tâches et des paramètres spécifiques, mais n’a pas pris en compte l’ensemble des défis que les modèles pourraient potentiellement rencontrer dans des applications réelles, ce qui souligne la nécessité d’environnements de test plus diversifiés.

Les travaux futurs pourraient consister à élargir la gamme des tâches et des conditions contrefactuelles pour découvrir davantage de faiblesses potentielles. Cela pourrait impliquer d’examiner des scénarios plus complexes et moins courants. L’équipe souhaite également améliorer l’interprétabilité en créant des méthodes permettant de mieux comprendre la logique derrière les processus de prise de décision des modèles.

« À mesure que les modèles linguistiques évoluent, la compréhension de leurs données de formation devient de plus en plus difficile, même pour les modèles ouverts, sans parler des modèles propriétaires », explique Hao Peng, professeur adjoint à l’Université de l’Illinois à Urbana-Champaign.

« La communauté reste perplexe quant à savoir si ces modèles se généralisent réellement à des tâches invisibles ou s’ils réussissent apparemment à mémoriser les données d’entraînement. Cet article fait d’importantes avancées dans la réponse à cette question. Il construit une série d’évaluations contrefactuelles soigneusement conçues, offrant de nouvelles perspectives sur les capacités des LLM de pointe. Il révèle que leur capacité à résoudre des tâches invisibles est peut-être beaucoup plus limitée que prévu par beaucoup. Il a le potentiel d’inspirer de futures recherches visant à identifier les modes d’échec des modèles actuels et à en développer de meilleurs. »

Parmi les autres auteurs figurent Najoung Kim, professeur adjoint à l’université de Boston et chercheur invité chez Google, ainsi que sept affiliés du CSAIL : les étudiants au doctorat en génie électrique et informatique (EECS) du MIT Linlu Qiu, Alexis Ross, Ekin Akyürek SM et Boyuan Chen ; l’ancien postdoctorant et chercheur en IA/ML d’Apple Bailin Wang ; et les professeurs adjoints de l’EECS Jacob Andreas et Yoon Kim.

L’équipe a présenté ses travaux au chapitre nord-américain de l’Association for Computational Linguistics (NAACL) le mois dernier.

Plus d’information:

Zhaofeng Wu et al., Raisonnement ou récitation ? Exploration des capacités et des limites des modèles linguistiques à travers des tâches contrefactuelles, arXiv (2023). DOI: 10.48550/arxiv.2307.02477

arXiv

Fourni par le Massachusetts Institute of Technology

Cet article est republié avec l’aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l’actualité de la recherche, de l’innovation et de l’enseignement au MIT.

Citation:Les capacités de raisonnement des grands modèles linguistiques sont souvent surestimées, selon les chercheurs (2024, 11 juillet) récupéré le 11 juillet 2024 à partir de

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni à titre d’information uniquement.