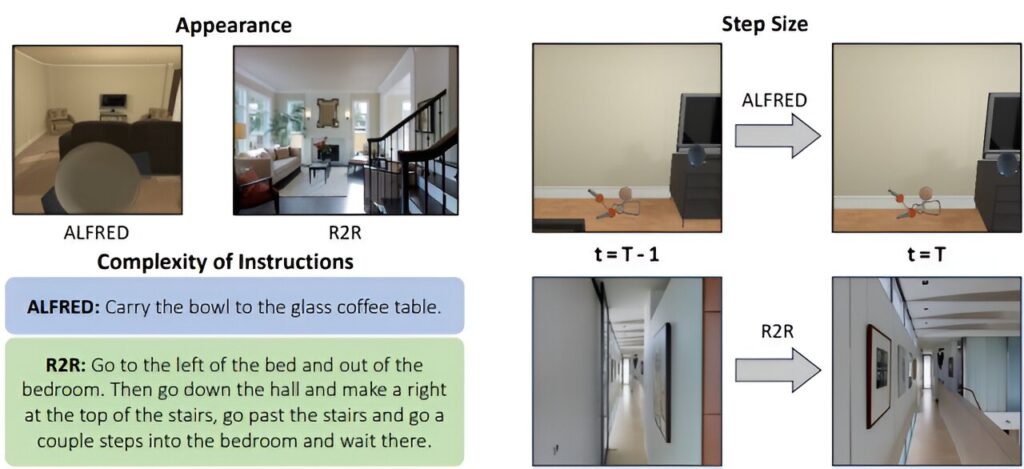

Écart de tâches entre ALFRED et R2R. Nous mettons en évidence des distinctions notables entre les tâches de navigation dans ALFRED et R2R, englobant des variations d'apparence, de taille de pas et de complexité des instructions. Crédit: arXiv (2023). DOI : 10.48550/arxiv.2310.07889

Un jour, vous souhaiterez peut-être que votre robot domestique transporte une charge de vêtements sales en bas et les dépose dans la machine à laver située dans le coin le plus à gauche du sous-sol. Le robot devra combiner vos instructions avec ses observations visuelles pour déterminer les étapes à suivre pour accomplir cette tâche.

Pour un agent IA, c’est plus facile à dire qu’à faire. Les approches actuelles utilisent souvent plusieurs modèles d’apprentissage automatique élaborés à la main pour aborder différentes parties de la tâche, dont la construction nécessite beaucoup d’efforts humains et d’expertise. Ces méthodes, qui utilisent des représentations visuelles pour prendre directement des décisions de navigation, nécessitent des quantités massives de données visuelles pour la formation, souvent difficiles à obtenir.

Pour surmonter ces défis, des chercheurs du MIT et du MIT-IBM Watson AI Lab ont conçu une méthode de navigation qui convertit les représentations visuelles en morceaux de langage, qui sont ensuite intégrés dans un grand modèle de langage qui réalise toutes les parties de la tâche de navigation en plusieurs étapes.

Plutôt que d'encoder des caractéristiques visuelles à partir d'images de l'environnement d'un robot sous forme de représentations visuelles, ce qui nécessite beaucoup de calculs, leur méthode crée des légendes textuelles décrivant le point de vue du robot. Un grand modèle linguistique utilise les légendes pour prédire les actions qu'un robot doit entreprendre pour exécuter les instructions linguistiques d'un utilisateur.

Parce que leur méthode utilise des représentations purement linguistiques, ils peuvent utiliser un grand modèle de langage pour générer efficacement une énorme quantité de données de formation synthétiques.

Bien que cette approche ne surpasse pas les techniques utilisant des fonctionnalités visuelles, elle fonctionne bien dans les situations où il manque suffisamment de données visuelles pour la formation. Les chercheurs ont découvert que la combinaison de leurs entrées linguistiques avec des signaux visuels permet d’obtenir de meilleures performances de navigation.

“En utilisant uniquement le langage comme représentation perceptuelle, notre approche est plus simple. Puisque toutes les entrées peuvent être codées sous forme de langage, nous pouvons générer une trajectoire compréhensible par l'homme”, explique Bowen Pan, spécialiste en génie électrique et informatique (EECS). étudiant diplômé et auteur principal d'un article sur cette approche, publié sur le arXiv serveur de préimpression.

Résoudre un problème de vision avec le langage

Étant donné que les grands modèles de langage sont les modèles d'apprentissage automatique les plus puissants disponibles, les chercheurs ont cherché à les intégrer dans la tâche complexe connue sous le nom de navigation vision-langage, explique Pan.

Mais ces modèles acceptent des entrées textuelles et ne peuvent pas traiter les données visuelles de la caméra d'un robot. L’équipe devait donc trouver un moyen d’utiliser le langage à la place.

Leur technique utilise un modèle de sous-titrage simple pour obtenir des descriptions textuelles des observations visuelles d'un robot. Ces légendes sont combinées avec des instructions basées sur le langage et intégrées dans un grand modèle de langage, qui décide quelle étape de navigation le robot doit suivre ensuite.

Le grand modèle de langage génère une légende de la scène que le robot devrait voir après avoir terminé cette étape. Ceci est utilisé pour mettre à jour l’historique de la trajectoire afin que le robot puisse suivre où il se trouve.

Le modèle répète ces processus pour générer une trajectoire qui guide le robot vers son objectif, une étape à la fois.

Pour rationaliser le processus, les chercheurs ont conçu des modèles afin que les informations d'observation soient présentées au modèle sous une forme standard, sous la forme d'une série de choix que le robot peut faire en fonction de son environnement.

Par exemple, une légende pourrait dire « à 30 degrés à votre gauche se trouve une porte avec une plante en pot à côté, à votre dos se trouve un petit bureau avec un bureau et un ordinateur », etc. Le modèle choisit si le robot doit se déplacer vers la porte ou le bureau.

“L'un des plus grands défis consistait à trouver comment coder correctement ce type d'informations dans un langage permettant à l'agent de comprendre quelle était la tâche et comment il devait y répondre”, explique Pan.

Avantages de la langue

Lorsqu’ils ont testé cette approche, même si elle ne pouvait pas surpasser les techniques basées sur la vision, ils ont constaté qu’elle offrait plusieurs avantages.

Premièrement, comme la synthèse d’un texte nécessite moins de ressources informatiques que des données d’image complexes, leur méthode peut être utilisée pour générer rapidement des données d’entraînement synthétiques. Au cours d'un test, ils ont généré 10 000 trajectoires synthétiques basées sur 10 trajectoires visuelles réelles.

La technique peut également combler le fossé qui peut empêcher un agent formé dans un environnement simulé de bien fonctionner dans le monde réel. Cet écart se produit souvent parce que les images générées par ordinateur peuvent apparaître très différentes des scènes du monde réel en raison d'éléments tels que l'éclairage ou la couleur. Mais un langage décrivant une image synthétique par rapport à une image réelle serait beaucoup plus difficile à distinguer, dit Pan.

De plus, les représentations utilisées par leur modèle sont plus faciles à comprendre pour un humain car elles sont écrites en langage naturel.

“Si l'agent ne parvient pas à atteindre son objectif, nous pouvons plus facilement déterminer où et pourquoi il a échoué. Peut-être que les informations historiques ne sont pas assez claires ou que l'observation ignore certains détails importants”, explique Pan.

De plus, leur méthode pourrait être appliquée plus facilement à des tâches et des environnements variés car elle n’utilise qu’un seul type d’entrée. Tant que les données peuvent être codées sous forme de langage, elles peuvent utiliser le même modèle sans apporter aucune modification.

Mais un inconvénient est que leur méthode perd naturellement certaines informations qui seraient capturées par les modèles basés sur la vision, comme les informations sur la profondeur.

Cependant, les chercheurs ont été surpris de constater que la combinaison de représentations basées sur le langage avec des méthodes basées sur la vision améliore la capacité d'un agent à naviguer.

“Cela signifie peut-être que le langage peut capturer des informations de niveau supérieur qui ne peuvent pas être capturées avec des fonctionnalités de vision pure”, dit-il.

C’est un domaine que les chercheurs souhaitent continuer à explorer. Ils souhaitent également développer un sous-titreur orienté navigation qui pourrait améliorer les performances de la méthode. En outre, ils souhaitent étudier la capacité des grands modèles linguistiques à présenter une conscience spatiale et voir comment cela pourrait faciliter la navigation basée sur le langage.

Plus d'information:

Bowen Pan et al, LangNav : Le langage comme représentation perceptuelle pour la navigation, arXiv (2023). DOI : 10.48550/arxiv.2310.07889

arXiv

Fourni par le Massachusetts Institute of Technology

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche, de l'innovation et de l'enseignement du MIT.

Citation: Une nouvelle méthode utilise des entrées basées sur le langage au lieu de données visuelles coûteuses pour aider les robots à naviguer (12 juin 2024) récupéré le 12 juin 2024 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.