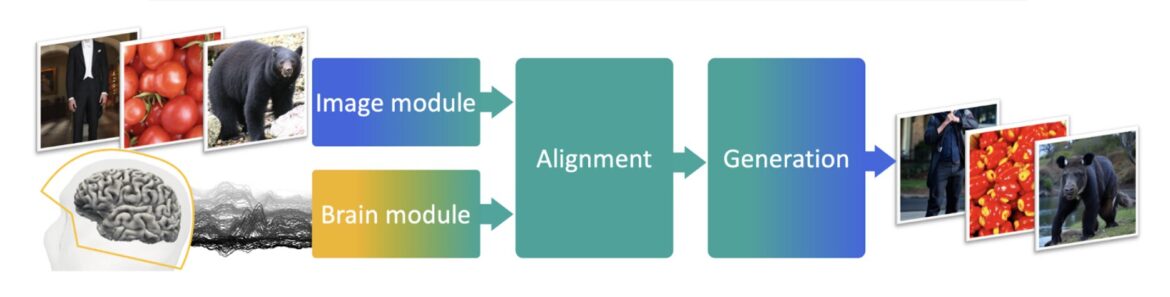

Les enregistrements MEG sont continuellement alignés sur la représentation profonde des images, ce qui peut alors conditionner la génération des images à chaque instant. Crédit : Défossez et al.

Les progrès technologiques récents ont ouvert des opportunités inestimables pour aider les personnes souffrant d’un handicap ou d’un handicap. Par exemple, ils ont permis la création d’outils pour soutenir la réadaptation physique, mettre en pratique les compétences sociales et fournir une assistance quotidienne dans des tâches spécifiques.

Les chercheurs de Meta AI ont récemment développé une méthode prometteuse et non invasive pour décoder la parole à partir de l’activité cérébrale d’une personne, ce qui pourrait permettre aux personnes incapables de parler de relayer leurs pensées via une interface informatique. Leur méthode proposée, présentée dans Intelligence des machines naturellesfusionne l’utilisation d’une technique d’imagerie et l’apprentissage automatique.

“Après un accident vasculaire cérébral ou une maladie cérébrale, de nombreux patients perdent leur capacité à parler”, a déclaré Jean Rémi King, chercheur scientifique chez Meta, à Medical Xpress. « Ces dernières années, des progrès majeurs ont été réalisés dans le développement d’une prothèse neurale : un dispositif, généralement implanté dans le cortex moteur des patients, qui peut être utilisé, grâce à l’IA, pour contrôler une interface informatique. , nécessite toujours une intervention chirurgicale au cerveau et n’est donc pas sans risques.

En plus de nécessiter des interventions chirurgicales, la plupart des approches proposées pour décoder la parole reposent sur des électrodes implantées et garantir le bon fonctionnement de ces électrodes pendant plus de quelques mois est un défi. L’objectif principal de l’étude récente menée par King et ses collègues était d’explorer une voie alternative non invasive pour décoder les représentations vocales.

“Au lieu d’utiliser des électrodes intracrâniennes, nous utilisons la magnéto-encéphalographie”, a expliqué King. “Il s’agit d’une technique d’imagerie reposant sur un appareil non invasif capable de prendre plus d’un millier d’instantanés de l’activité cérébrale par seconde. Comme ces signaux cérébraux sont très difficiles à interpréter, nous formons un système d’IA pour les décoder en segments vocaux.”

Essentiellement, King et ses collègues ont développé un système d’IA et l’ont formé pour analyser les images de magnéto-encéphalographie, prédisant la parole à partir de l’activité cérébrale qui y est enregistrée. Leur système d’IA se compose de deux modules clés, appelés « module cérébral » et « module vocal ».

Le module cérébral a été formé pour extraire des informations de l’activité cérébrale humaine enregistrée par magnéto-encéphalographie. Le module vocal, quant à lui, identifie les représentations vocales qui doivent être décodées.

“Les deux modules sont paramétrés de telle sorte que nous pouvons déduire, à chaque instant, ce qui est entendu par le participant”, a déclaré King.

Les chercheurs ont évalué l’approche proposée dans une première étude impliquant 175 participants humains. Ces participants ont été invités à écouter des histoires courtes racontées et des phrases prononcées isolées pendant que leur activité cérébrale était enregistrée par magnéto-encéphalographie, ou une technique alternative connue sous le nom d’électroencéphalographie.

L’équipe a obtenu les meilleurs résultats en analysant trois secondes de signaux magnéto-encéphalographiques. Plus précisément, ils ont pu décoder les segments vocaux correspondants avec une précision moyenne allant jusqu’à 41 % sur plus de 1 000 possibilités parmi les participants, mais avec certains participants, ils ont atteint des précisions allant jusqu’à 80 %.

“Nous avons été surpris par les performances de décodage obtenues”, a déclaré King. “Dans la plupart des cas, nous pouvons récupérer ce que les participants entendent, et si le décodeur fait une erreur, celle-ci a tendance à être sémantiquement similaire à la phrase cible.”

Le système de décodage vocal proposé par l’équipe se compare favorablement à diverses approches de base, soulignant sa valeur potentielle pour les applications futures. Comme il ne nécessite pas de procédures chirurgicales invasives ni l’utilisation d’implants cérébraux, il pourrait également être plus facile à mettre en œuvre dans des contextes réels.

“Notre équipe se consacre à la recherche fondamentale : comprendre comment fonctionne le cerveau et comment ce fonctionnement peut être lié et informer l’IA”, a déclaré King. “Il y a un long chemin à parcourir avant une application pratique, mais nous espérons que ce développement pourra aider les patients dont la communication est limitée ou empêchée par la paralysie. La prochaine étape majeure, à cet égard, consiste à aller au-delà du décodage de la parole perçue et à décoder produit de la parole. »

Le système basé sur l’IA des chercheurs en est encore à ses premiers stades de développement et nécessitera des améliorations significatives avant de pouvoir être testé et introduit en milieu clinique. Néanmoins, ces travaux récents ont dévoilé le potentiel de création de technologies moins invasives pour aider les patients souffrant de troubles de la parole.

“Notre équipe se concentre principalement sur la compréhension du fonctionnement du cerveau”, a ajouté King. “Nous essayons ainsi de développer ces outils pour quantifier et comprendre les similitudes entre l’IA et le cerveau, non seulement dans le contexte de la parole, mais aussi pour d’autres modalités, comme la perception visuelle.”

Plus d’information:

Alexandre Défossez et al, Décoder la perception de la parole à partir d’enregistrements cérébraux non invasifs, Intelligence des machines naturelles (2023). DOI : 10.1038/s42256-023-00714-5.

© 2023 Réseau Science X

Citation: Meta AI développe une méthode non invasive pour décoder la parole à partir de l’activité cérébrale (28 novembre 2023) récupéré le 28 novembre 2023 sur

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.