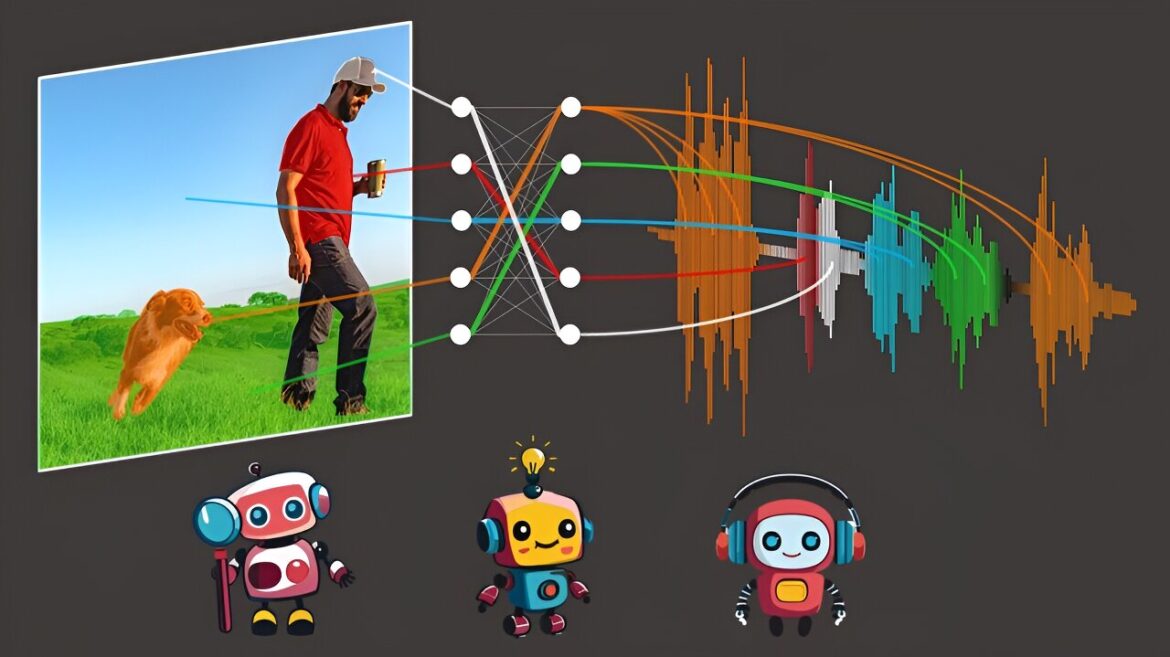

L'algorithme DenseAV apprend le sens du langage uniquement en associant des signaux audio et vidéo. Crédit : Mark Hamilton

Mark Hamilton, titulaire d'un doctorat au MIT. étudiant en génie électrique et informatique et affilié au Laboratoire d'informatique et d'intelligence artificielle (CSAIL) du MIT, souhaite utiliser des machines pour comprendre comment les animaux communiquent. Pour ce faire, il a d’abord entrepris de créer un système capable d’apprendre le langage humain « à partir de zéro ».

“Assez drôle, le moment clé de l'inspiration est venu du film “La Marche des Pingouins”. Il y a une scène où un pingouin tombe en traversant la glace et laisse échapper un petit gémissement persistant en se relevant. Quand on le regarde, il est presque évident que ce gémissement remplace un mot de quatre lettres. C'est le moment où on a pensé. , peut-être que nous devons utiliser l'audio et la vidéo pour apprendre une langue. dit Hamilton. “Y a-t-il un moyen de laisser un algorithme regarder la télévision toute la journée et, à partir de là, comprendre de quoi nous parlons ?”

“Notre modèle, DenseAV, vise à apprendre une langue en prédisant ce qu'il voit à partir de ce qu'il entend, et vice-versa. Par exemple, si vous entendez le son de quelqu'un disant 'faites cuire le gâteau à 350', il y a de fortes chances que vous voyiez un un gâteau ou un four. Pour réussir ce jeu de correspondance audio-vidéo à travers des millions de vidéos, le modèle doit apprendre de quoi les gens parlent”, explique Hamilton.

Un article décrivant le travail paraît sur le arXiv serveur de préimpression.

Une fois qu'ils ont formé DenseAV à ce jeu de correspondance, Hamilton et ses collègues ont examiné quels pixels le modèle recherchait lorsqu'il entendait un son. Par exemple, lorsque quelqu'un dit « chien », l'algorithme commence immédiatement à rechercher des chiens dans le flux vidéo. En voyant quels pixels sont sélectionnés par l’algorithme, on peut découvrir ce que l’algorithme pense qu’un mot signifie.

Il est intéressant de noter qu’un processus de recherche similaire se produit lorsque DenseAV écoute un chien aboyer : il recherche un chien dans le flux vidéo.

“Cela a piqué notre intérêt. Nous voulions voir si l'algorithme connaissait la différence entre le mot” chien “et l'aboiement d'un chien”, explique Hamilton. L’équipe a exploré cela en dotant le DenseAV d’un « cerveau à deux faces ». Fait intéressant, ils ont découvert qu’un côté du cerveau de DenseAV se concentrait naturellement sur le langage, comme le mot « chien », et que l’autre côté se concentrait sur des sons comme les aboiements. Cela a montré que DenseAV a non seulement appris la signification des mots et l'emplacement des sons, mais a également appris à distinguer ces types de connexions multimodales, le tout sans intervention humaine ni aucune connaissance du langage écrit.

Une branche d’applications apprend de la quantité massive de vidéos publiées chaque jour sur Internet.

“Nous voulons des systèmes capables d'apprendre à partir d'énormes quantités de contenu vidéo, telles que des vidéos pédagogiques”, explique Hamilton. « Une autre application passionnante consiste à comprendre de nouvelles langues, comme la communication avec les dauphins ou les baleines, qui n'ont pas de forme de communication écrite. Nous espérons que DenseAV pourra nous aider à comprendre ces langues qui ont échappé aux efforts de traduction humaine depuis le début. J'espère que cette méthode pourra être utilisée pour découvrir des modèles entre d'autres paires de signaux, comme les sons sismiques émis par la terre et sa géologie.

Un formidable défi attendait l'équipe : apprendre une langue sans aucune saisie de texte. Leur objectif était de redécouvrir le sens du langage à partir de zéro, en évitant d’utiliser des modèles linguistiques pré-entraînés. Cette approche s'inspire de la façon dont les enfants apprennent en observant et en écoutant leur environnement pour comprendre le langage.

Pour réaliser cet exploit, DenseAV utilise deux composants principaux pour traiter séparément les données audio et visuelles. Cette séparation empêchait l'algorithme de tricher, en laissant le côté visuel regarder l'audio et vice versa. Cela a forcé l’algorithme à reconnaître les objets et a créé des fonctionnalités détaillées et significatives pour les signaux audio et visuels. DenseAV apprend en comparant des paires de signaux audio et visuels pour trouver quels signaux correspondent et lesquels ne correspondent pas. Cette méthode, appelée apprentissage contrastif, ne nécessite pas d'exemples étiquetés et permet à DenseAV de comprendre les modèles prédictifs importants du langage lui-même.

Une différence majeure entre DenseAV et les algorithmes précédents est que les travaux antérieurs se concentraient sur une seule notion de similarité entre le son et les images. Un clip audio entier comme quelqu'un disant « le chien était assis sur l'herbe » a été associé à une image entière d'un chien. Cela ne permettait pas aux méthodes précédentes de découvrir des détails fins, comme le lien entre le mot « herbe » et l’herbe située sous le chien.

L'algorithme de l'équipe recherche et regroupe toutes les correspondances possibles entre un clip audio et les pixels d'une image. Cela a non seulement amélioré les performances, mais a également permis à l’équipe de localiser avec précision les sons d’une manière que les algorithmes précédents ne pouvaient pas.

“Les méthodes conventionnelles utilisent un jeton de classe unique, mais notre approche compare chaque pixel et chaque seconde de son. Cette méthode plus fine permet à DenseAV d'établir des connexions plus détaillées pour une meilleure localisation”, explique Hamilton.

Les chercheurs ont formé DenseAV sur AudioSet, qui comprend 2 millions de vidéos YouTube. Ils ont également créé de nouveaux ensembles de données pour tester dans quelle mesure le modèle peut relier les sons et les images. Lors de ces tests, DenseAV a surpassé les autres modèles haut de gamme dans des tâches telles que l'identification d'objets à partir de leurs noms et de leurs sons, prouvant ainsi son efficacité.

“Les ensembles de données précédents ne prenaient en charge que des évaluations grossières, nous avons donc créé un ensemble de données à l'aide d'ensembles de données de segmentation sémantique. Cela permet d'obtenir des annotations au pixel près pour une évaluation précise des performances de notre modèle. Nous pouvons inciter l'algorithme avec des sons ou des images spécifiques et obtenir ces localisations détaillées. ” dit Hamilton.

En raison de la quantité massive de données impliquées, le projet a duré environ un an. L’équipe affirme que la transition vers une architecture de transformateur à grande échelle a présenté des défis, car ces modèles peuvent facilement négliger des détails fins. Encourager le modèle à se concentrer sur ces détails était un obstacle important.

Pour l’avenir, l’équipe vise à créer des systèmes capables d’apprendre à partir d’énormes quantités de données vidéo ou audio uniquement. Ceci est crucial pour les nouveaux domaines dans lesquels les deux modes sont nombreux, mais pas ensemble. Ils visent également à étendre cela en utilisant des structures de base plus grandes et éventuellement à intégrer les connaissances des modèles de langage pour améliorer les performances.

“La reconnaissance et la segmentation des objets visuels dans les images, ainsi que les sons environnementaux et les paroles dans les enregistrements audio, sont chacun des problèmes difficiles en soi. Historiquement, les chercheurs se sont appuyés sur des annotations coûteuses et fournies par l'homme afin de former des modèles d'apprentissage automatique pour accomplir ces tâches”, explique David Harwath, professeur adjoint en informatique à l'Université du Texas à Austin, qui n'a pas participé aux travaux.

“DenseAV fait des progrès significatifs dans le développement de méthodes capables d'apprendre à résoudre ces tâches simultanément en observant simplement le monde à travers la vue et le son, en se basant sur l'idée que les choses que nous voyons et avec lesquelles nous interagissons émettent souvent du son, et que nous utilisons également le langage parlé pour parler. Ce modèle ne fait pas non plus d'hypothèses sur la langue spécifique qui est parlée et pourrait donc en principe apprendre à partir de données dans n'importe quelle langue. Il serait passionnant de voir ce que DenseAV pourrait apprendre en l'étendant sur des milliers ou des millions d'heures. de données vidéo dans une multitude de langues.

Les autres auteurs sont Andrew Zisserman, professeur d'ingénierie de vision par ordinateur à l'Université d'Oxford ; John R. Hershey, chercheur sur la perception de l'IA chez Google ; et William T. Freeman, professeur de génie électrique et d'informatique au MIT et chercheur principal du CSAIL.

Plus d'information:

Mark Hamilton et al, Séparer le « Chirp » du « Chat » : mise à la terre visuelle auto-supervisée du son et du langage, arXiv (2024). arxiv.org/abs/2406.05629

arXiv

Fourni par le Massachusetts Institute of Technology

Cette histoire est republiée avec l'aimable autorisation de MIT News (web.mit.edu/newsoffice/), un site populaire qui couvre l'actualité de la recherche, de l'innovation et de l'enseignement du MIT.

Citation: Un nouvel algorithme découvre la langue simplement en regardant des vidéos (11 juin 2024) récupéré le 11 juin 2024 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.