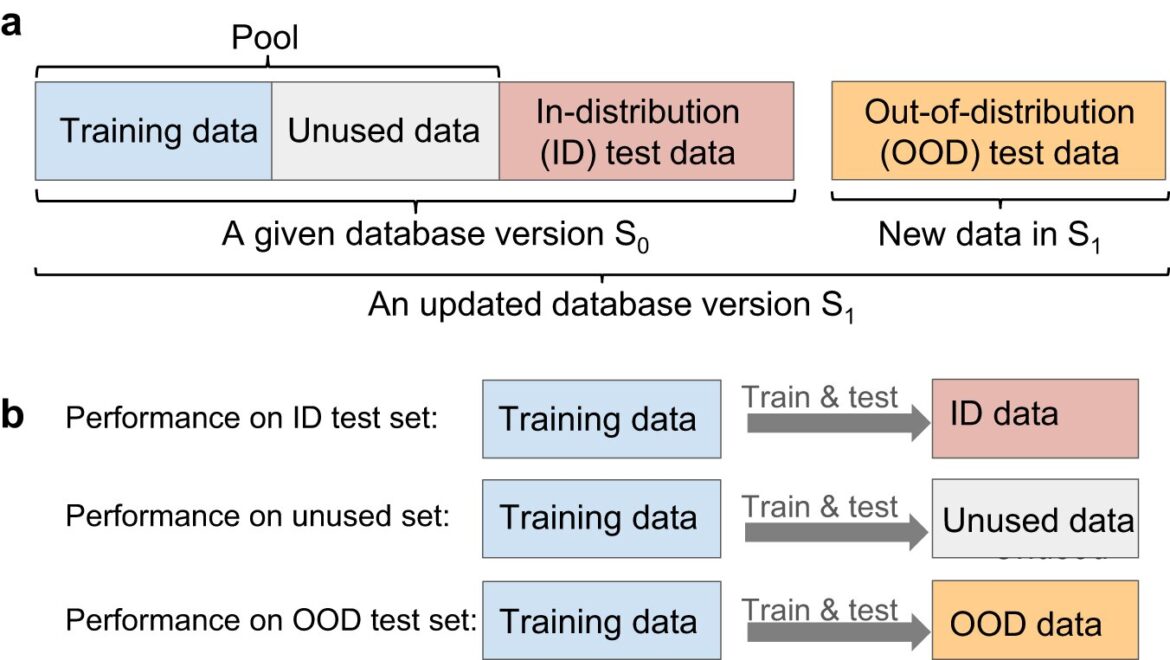

Schéma de l’évaluation de la redondance. Crédit: Communications naturelles (2023). DOI : 10.1038/s41467-023-42992-y

De ChatGPT à DALL-E, les algorithmes d’intelligence artificielle (IA) d’apprentissage profond sont appliqués à un nombre toujours croissant de domaines. Une nouvelle étude menée par des chercheurs en génie de l’Université de Toronto, publiée dans Communications naturelles, suggère que l’une des hypothèses fondamentales des modèles d’apprentissage profond – à savoir qu’ils nécessitent d’énormes quantités de données de formation – n’est peut-être pas aussi solide qu’on le pensait autrefois.

Le professeur Jason Hattrick-Simpers et son équipe se concentrent sur la conception de matériaux de nouvelle génération, depuis des catalyseurs qui convertissent le carbone capturé en carburant jusqu’aux surfaces antiadhésives qui maintiennent les ailes des avions sans givre.

L’un des défis dans ce domaine est l’énorme potentiel d’espace de recherche. Par exemple, l’Open Catalyst Project contient plus de 200 millions de points de données sur des matériaux catalyseurs potentiels, qui ne couvrent encore qu’une infime partie du vaste espace chimique qui peut, par exemple, cacher le bon catalyseur pour nous aider à lutter contre le changement climatique.

“Les modèles d’IA peuvent nous aider à rechercher efficacement cet espace et à limiter nos choix aux familles de matériaux les plus prometteuses”, explique Hattrick-Simpers.

“Traditionnellement, une quantité importante de données est considérée comme nécessaire pour former des modèles d’IA précis. Mais un ensemble de données comme celui du projet Open Catalyst est si volumineux qu’il faut des superordinateurs très puissants pour pouvoir y répondre. Il y a donc une question de l’équité ; nous devons trouver un moyen d’identifier des ensembles de données plus petits sur lesquels les personnes n’ayant pas accès à d’énormes quantités de puissance de calcul peuvent entraîner leurs modèles.

Mais cela soulève un deuxième défi : la plupart des ensembles de données sur les matériaux les plus petits actuellement disponibles ont été développés pour un domaine spécifique, par exemple l’amélioration des performances des électrodes de batterie.

Cela signifie qu’ils ont tendance à se regrouper autour de quelques compositions chimiques similaires à celles déjà utilisées aujourd’hui et peuvent manquer des possibilités qui pourraient être plus prometteuses, mais moins intuitivement évidentes.

“Imaginez si vous vouliez construire un modèle pour prédire les notes finales des étudiants sur la base des résultats des tests précédents”, explique le Dr Kangming Li, chercheur postdoctoral au laboratoire de Hattrick-Simpers. “Si vous l’entraîniez uniquement sur des étudiants du Canada, il pourrait parfaitement fonctionner dans ce contexte, mais il pourrait ne pas réussir à prédire avec précision les notes des étudiants de France ou du Japon. C’est la situation à laquelle nous sommes confrontés dans le monde des matériaux.”

Une solution possible pour relever les défis ci-dessus consiste à identifier des sous-ensembles de données à partir de très grands ensembles de données qui sont plus faciles à traiter, mais qui conservent néanmoins toute la gamme d’informations et la diversité présentes dans l’original.

Pour mieux comprendre comment les qualités des ensembles de données affectent les modèles qu’ils sont utilisés pour entraîner, Li a conçu des méthodes pour identifier des sous-ensembles de données de haute qualité à partir d’ensembles de données sur les matériaux précédemment publiés, tels que JARVIS, The Materials Project et l’Open Quantum Materials Database (OQMD). ). Ensemble, ces bases de données contiennent des informations sur plus d’un million de matériaux différents.

Li a construit un modèle informatique qui prédisait les propriétés des matériaux et l’a entraîné de deux manières : l’une utilisait l’ensemble de données d’origine, mais l’autre utilisait un sous-ensemble de ces mêmes données qui était environ 95 % plus petit.

“Ce que nous avons découvert, c’est qu’en essayant de prédire les propriétés d’un matériau contenu dans le domaine de l’ensemble de données, le modèle qui avait été formé sur seulement 5 % des données fonctionnait à peu près de la même manière que celui qui avait été formé sur toutes les données”, explique Li. “À l’inverse, en essayant de prédire les propriétés d’un matériau qui se trouvait en dehors du domaine de l’ensemble de données, les deux ont obtenu des résultats tout aussi médiocres.”

Li dit que les résultats suggèrent un moyen de mesurer le degré de redondance dans un ensemble de données donné : si davantage de données n’améliorent pas les performances du modèle, cela pourrait indiquer que ces données supplémentaires sont redondantes et ne fournissent pas de nouvelles informations à apprendre par les modèles. .

“Nos résultats révèlent également un degré préoccupant de redondance caché au sein de ces grands ensembles de données très recherchés”, explique Li.

L’étude souligne également ce que les experts en IA de nombreux domaines constatent : que même les modèles formés sur des ensembles de données relativement petits peuvent fonctionner correctement si les données sont de qualité suffisamment élevée.

“Tout cela est dû au fait qu’en termes d’utilisation de l’IA pour accélérer la découverte de matériaux, nous n’en sommes qu’au début”, explique Hattrick-Simpers.

“Ce que cela suggère, c’est qu’à mesure que nous avançons, nous devons vraiment réfléchir à la manière dont nous construisons nos ensembles de données. Cela est vrai, que cela soit fait de haut en bas, comme en sélectionnant un sous-ensemble de données à partir d’un ensemble de données beaucoup plus vaste, ou à partir du de bas en haut, comme pour l’échantillonnage de nouveaux matériaux à inclure.

“Nous devons prêter attention à la richesse de l’information, plutôt que de simplement rassembler autant de données que possible.”

Plus d’information:

Kangming Li et al, Exploiter la redondance dans de grands ensembles de données sur les matériaux pour un apprentissage automatique efficace avec moins de données, Communications naturelles (2023). DOI : 10.1038/s41467-023-42992-y

Fourni par l’Université de Toronto

Citation: Une nouvelle étude révèle que des ensembles de données plus volumineux ne sont peut-être pas toujours meilleurs pour les modèles d’IA (2023, 13 novembre) récupéré le 13 novembre 2023 sur

Ce document est soumis au droit d’auteur. En dehors de toute utilisation équitable à des fins d’étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.