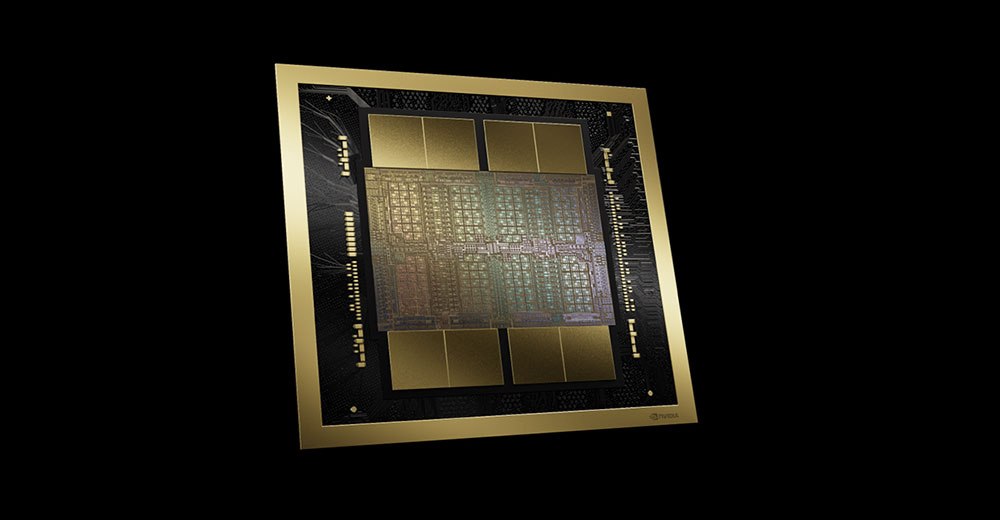

Nvidia augmente la puissance de sa gamme de puces d'intelligence artificielle avec l'annonce lundi de son architecture GPU Blackwell lors de sa première conférence sur la technologie GPU (GTC) en personne depuis cinq ans.

Selon Nvidia, la puce, conçue pour être utilisée dans les grands centres de données – ceux qui alimentent des sociétés comme AWS, Azure et Google – offre 20 PetaFLOPS de performances d'IA, soit 4 fois plus rapides sur les charges de travail de formation d'IA, 30 fois plus rapides sur les charges de travail d'entraînement d'IA. d'inférence des charges de travail et jusqu'à 25 fois plus économe en énergie que son prédécesseur.

Comparé à son prédécesseur, le H100 « Hopper », le B200 Blackwell est à la fois plus puissant et plus économe en énergie, a affirmé Nvidia. Pour entraîner un modèle d’IA de la taille de GPT-4, par exemple, il faudrait 8 000 puces H100 et 15 mégawatts de puissance. Cette même tâche ne nécessiterait que 2 000 puces B200 et quatre mégawatts de puissance.

“Il s'agit de la première grande avancée de l'entreprise dans la conception de puces depuis les débuts de l'architecture Hopper il y a deux ans”, a écrit Bob O'Donnell, fondateur et analyste en chef de Technalysis Research, dans sa newsletter hebdomadaire LinkedIn.

Exercice de reconditionnement

Cependant, Sébastien Jean, directeur technique de Phison Electronics, une société d'électronique taïwanaise, a qualifié la puce d'« exercice de reconditionnement ».

“C'est bien, mais ce n'est pas révolutionnaire”, a-t-il déclaré à TechNewsWorld. “Il fonctionnera plus rapidement, consommera moins d'énergie et permettra davantage de calculs dans une zone plus petite, mais du point de vue du technologue, ils l'ont simplement réduit sans vraiment changer quoi que ce soit de fondamental.”

« Cela signifie que leurs résultats sont facilement reproduits par leurs concurrents », a-t-il déclaré. “Même s'il est utile d'être le premier, car pendant que vos concurrents rattrapent leur retard, vous passez à l'étape suivante.”

« Lorsque vous forcez vos concurrents à se lancer dans un jeu de rattrapage permanent, à moins qu'ils n'aient un leadership très fort, ils tomberont dans une mentalité de « suiveurs rapides » sans s'en rendre compte », a-t-il déclaré.

“En étant agressif et en étant le premier”, a-t-il poursuivi, “Nvidia peut cimenter l'idée qu'ils sont les seuls véritables innovateurs, ce qui stimule la demande pour leurs produits.”

Bien que Blackwell puisse être un exercice de reconditionnement, a-t-il ajouté, il présente un réel avantage net. “En termes pratiques, les utilisateurs de Blackwell seront en mesure de faire plus de calculs plus rapidement pour le même budget d'énergie et d'espace”, a-t-il noté. “Cela permettra aux solutions basées sur Blackwell de devancer et de surpasser leurs concurrents.”

Prise compatible avec le passé

O'Donnell a affirmé que le moteur de transformateur de deuxième génération de l'architecture Blackwell constitue une avancée significative car il réduit les calculs en virgule flottante de l'IA à quatre bits au lieu de huit bits. “En pratique, en réduisant ces calculs par rapport aux 8 bits des générations précédentes, ils peuvent doubler les performances de calcul et les tailles de modèles qu'ils peuvent prendre en charge sur Blackwell avec ce seul changement”, a-t-il déclaré.

Les nouvelles puces sont également compatibles avec leurs prédécesseurs. “Si vous possédez déjà des systèmes Nvidia avec le H100, Blackwell est compatible enfichable”, a observé Jack E. Gold, fondateur et analyste principal chez J.Gold Associates, une société de conseil informatique à Northborough, Massachusetts.

“En théorie, vous pourriez simplement débrancher les H100 et brancher les Blackwell”, a-t-il déclaré à TechNewsWorld. « Même si vous pouvez le faire en théorie, vous ne pourrez peut-être pas le faire financièrement. » Par exemple, la puce H100 de Nvidia coûte entre 30 000 et 40 000 dollars pièce. Bien que Nvidia n'ait pas révélé le prix de sa nouvelle gamme de puces IA, les prix suivront probablement ces lignes.

Gold a ajouté que les puces Blackwell pourraient aider les développeurs à produire de meilleures applications d'IA. “Plus vous pouvez analyser de points de données, plus l'IA s'améliore”, a-t-il expliqué. “Ce dont parle Nvidia avec Blackwell, c'est qu'au lieu de pouvoir analyser des milliards de points de données, vous pouvez en analyser des milliards.”

Les microservices d'inférence Nvidia (NIM) ont également été annoncés lors du GTC. “Les outils NIM sont construits sur la plate-forme CUDA de Nvidia et permettront aux entreprises d'introduire des applications personnalisées et des modèles d'IA pré-entraînés dans les environnements de production, ce qui devrait aider ces entreprises à commercialiser de nouveaux produits d'IA”, Brian Colello, stratège actions chez Morningstar Research. Services, à Chicago, a écrit mardi dans une note d'analyste.

Aider à déployer l'IA

« Les grandes entreprises dotées de centres de données peuvent adopter et déployer de nouvelles technologies rapidement, mais la plupart des êtres humains travaillent dans des petites et moyennes entreprises qui n'ont pas les ressources nécessaires pour acheter, personnaliser et déployer de nouvelles technologies. Tout ce qui peut les aider à adopter de nouvelles technologies et à les déployer plus facilement, comme NIM, leur sera bénéfique », a expliqué Shane Rau, analyste des semi-conducteurs chez IDC, une société mondiale d'études de marché.

“Avec NIM, vous trouverez des modèles spécifiques à ce que vous voulez faire”, a-t-il déclaré à TechNewsWorld. « Tout le monde ne veut pas faire de l’IA en général. Ils veulent faire de l'IA spécifiquement pertinente pour leur entreprise ou leur entreprise.

Même si le NIM n'est pas aussi intéressant que les dernières conceptions matérielles, O'Donnell a noté qu'il est nettement plus important à long terme pour plusieurs raisons.

« Premièrement », a-t-il écrit, « cela est censé permettre aux entreprises de passer plus rapidement et plus efficacement des expériences GenAI et des POC (preuves de concept) à la production dans le monde réel. Il n'y a tout simplement pas assez de data scientists et d'experts en programmation GenAI, c'est pourquoi de nombreuses entreprises désireuses de déployer GenAI ont été limitées par des défis techniques. En conséquence, c'est formidable de voir Nvidia contribuer à faciliter ce processus.

« Deuxièmement », a-t-il poursuivi, « ces nouveaux microservices permettent la création d'une toute nouvelle source de revenus et d'une toute nouvelle stratégie commerciale pour Nvidia, car ils peuvent être concédés sous licence par GPU/heure (ainsi que d'autres variantes). Cela pourrait s'avérer être un moyen important, durable et plus diversifié de générer des revenus pour Nvidia, donc même si ce n'est qu'un début, il sera important de surveiller cela.

Leader retranché

Rau a prédit que Nvidia restera la plate-forme de traitement d'IA de choix dans un avenir prévisible. “Mais des concurrents comme AMD et Intel seront en mesure de conquérir des parts modestes du marché des GPU”, a-t-il déclaré. Et comme il existe différentes puces que vous pouvez utiliser pour l’IA – microprocesseurs, FPGA et ASIC – ces technologies concurrentes se disputeront des parts de marché et se développeront.

“Il y a très peu de menaces pour la domination de Nvidia sur ce marché”, a ajouté Abdullah Anwer Ahmed, fondateur de Serene Data Ops, une société de gestion de données à San Francisco.

“En plus de leur matériel supérieur, leur solution logicielle CUDA constitue la base des segments sous-jacents de l'IA depuis plus d'une décennie”, a-t-il déclaré à TechNewsWorld.

« La principale menace est qu'Amazon, Google et Microsoft/OpenAI travaillent à la construction de leurs propres puces optimisées autour de ces modèles », a-t-il poursuivi. « Google a déjà sa puce 'TPU' en production. Amazon et OpenAI ont fait allusion à des projets similaires.

“Dans tous les cas, construire ses propres GPU est une option réservée aux plus grandes entreprises”, a-t-il ajouté. “La plupart des acteurs du secteur LLM continueront à acheter des GPU Nvidia.”