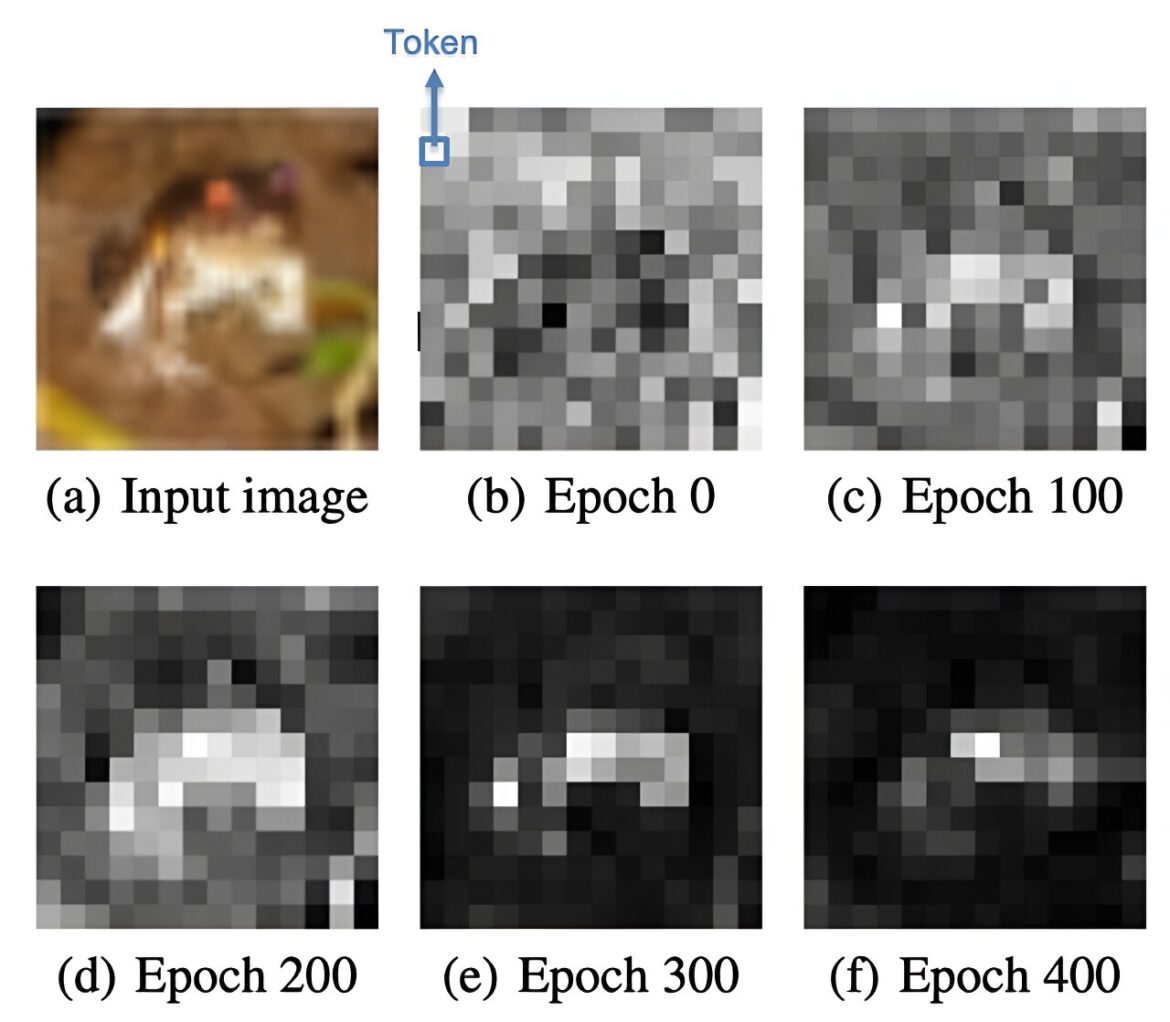

Dans ce cas de test de l'étude, un modèle de transformateur se concentre sur la partie pertinente de l'image (la grenouille) sur des centaines de cycles d'entraînement (époques). Au début, l’attention est dirigée de manière aléatoire autour de l’image. Mais avec l'entraînement, le modèle apprend à ignorer les parties de l'image qui ne sont pas la grenouille. Crédit : Davoud Ataee Tarzanagh et Xuechen Zhang, SOTA Lab, Université du Michigan

Les utilisateurs de chatbot recommandent souvent de traiter une série d'invites comme une conversation, mais comment le chatbot sait-il à quoi vous faites référence ? Une nouvelle étude révèle le mécanisme utilisé par les modèles de transformateurs, comme ceux qui pilotent les chatbots modernes, pour décider à quoi prêter attention.

“Disons que vous avez un texte très long et que vous demandez au chatbot d'identifier les sujets clés, de les agréger et de les résumer. Pour ce faire, vous devez être capable de vous concentrer exactement sur les bons types de détails, ” a déclaré Samet Oymak, professeur adjoint de génie électrique et informatique à l'Université du Michigan, qui a supervisé l'étude qui sera présentée à la conférence sur les systèmes de traitement de l'information neuronale le mercredi 13 décembre.

“Nous avons montré mathématiquement pour la première fois comment les transformateurs apprennent à faire cela”, a-t-il déclaré.

Les architectures Transformer, proposées pour la première fois en 2017, ont révolutionné le traitement du langage naturel car elles sont si efficaces pour consommer de très longues chaînes de texte : GPT-4 peut gérer des livres entiers. Les transformateurs divisent le texte en morceaux plus petits, appelés jetons, qui sont traités en parallèle tout en conservant le contexte autour de chaque mot. Le grand modèle de langage GPT a passé des années à digérer du texte provenant d'Internet avant d'entrer en scène avec un chatbot si familier qu'il pourrait réussir l'examen du barreau.

La clé des transformateurs est le mécanisme d’attention : ils décident quelles informations sont les plus pertinentes. Ce que l'équipe d'Oymak a découvert, c'est qu'une partie de la méthode utilisée par un transformateur pour y parvenir est assez ancienne : ils utilisent essentiellement des machines à vecteurs de support inventées il y a 30 ans. Un SVM définit une limite afin que les données appartiennent à l'une des deux catégories suivantes. Par exemple, ils sont utilisés pour identifier les sentiments positifs et négatifs dans les avis clients. Il s’avère que les transformateurs font quelque chose de similaire en décidant à quoi prêter attention et quoi ignorer.

Même si vous semblez parler à une personne, ChatGPT fait en fait des mathématiques multidimensionnelles. Chaque élément de texte devient une chaîne de nombres appelée vecteur. La première fois que vous entrez une invite, ChatGPT utilise son mécanisme d'attention mathématique pour attacher des poids à chaque vecteur, et donc à chaque mot et combinaison de mots, afin de décider lequel prendre en compte lors de la formulation de sa réponse. Il s'agit d'un algorithme de prédiction de mots, il commence donc par prédire le premier mot susceptible de déclencher une bonne réponse, puis le suivant et le suivant, jusqu'à ce que la réponse soit complète.

Ensuite, lorsque vous entrez l'invite suivante, cela vous semble être une continuation de la conversation, mais ChatGPT lit en fait toute la conversation depuis le début, attribue de nouvelles pondérations à chaque jeton, puis formule une réponse basée sur cette nouvelle évaluation. C’est ainsi qu’il donne l’impression de pouvoir se remémorer quelque chose dit plus tôt. C'est aussi pourquoi, si on lui donne les cent premiers vers de Roméo et Juliette et qu'on lui demande d'expliquer le problème entre les Montaigu et les Capulet, il peut résumer les interactions les plus pertinentes.

On savait déjà beaucoup de choses sur le fonctionnement des réseaux neuronaux à transformateur. Cependant, les architectures de transformateurs ne sont pas conçues avec un seuil explicite quant à ce à quoi il faut prêter attention et ce à quoi il ne faut pas prêter attention. C'est à cela que sert le mécanisme de type SVM.

“Nous ne comprenons pas ce que font ces modèles de boîtes noires, et ils se généralisent”, a déclaré Oymak. “C'est l'une des premières études à montrer clairement comment le mécanisme d'attention peut trouver et récupérer une aiguille d'informations utiles dans une botte de foin de texte.”

L’équipe a l’intention d’utiliser ces connaissances pour rendre les grands modèles de langage plus efficaces et plus faciles à interpréter, et elle prévoit que cela sera utile à d’autres personnes travaillant sur des aspects de l’IA où l’attention est importante, comme la perception, le traitement d’images et le traitement audio.

Un deuxième article, approfondissant le sujet, sera présenté lors de l'atelier Mathematics of Modern Machine Learning de NeurIPS 2023 : Transformers as support vector machines.

Plus d'information:

Sélection de jetons à marge maximale dans le mécanisme d'attention (2023).

Fourni par l'Université du Michigan

Citation: Comprendre l'attention dans les grands modèles de langage (13 décembre 2023) récupéré le 13 décembre 2023 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.