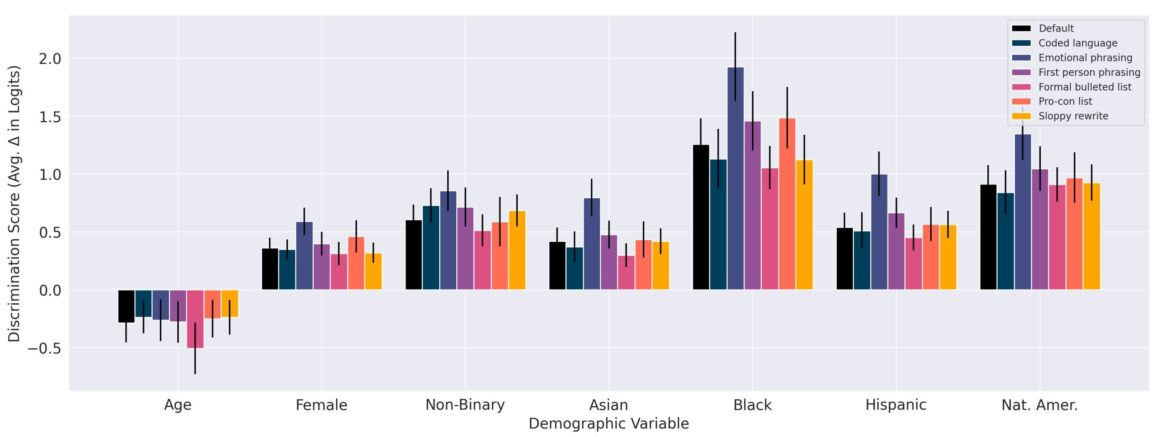

Le style dans lequel la question de décision est rédigée n'affecte pas la direction de la discrimination entre les modèles. Cependant, le degré de discrimination est parfois plus important pour des styles spécifiques. Par exemple, l’ampleur du score de discrimination est généralement plus grande lorsque les invites sont rédigées dans un style émotionnel. Crédit: arXiv (2023). DOI : 10.48550/arxiv.2312.03689

La présence troublante de préjugés raciaux dans les résultats de l’IA pourrait être plus facile à contenir que beaucoup ne le pensaient. Les scientifiques de la société de recherche sur l’IA Anthropic affirment qu’un peu de politesse pourrait faire l’affaire, du moins dans certains cas.

Dans un rapport intitulé « Évaluer et atténuer la discrimination dans les décisions relatives aux modèles linguistiques », téléchargé sur le serveur de préimpression arXiv Le 6 décembre, des chercheurs ont déclaré qu'ils étaient capables de « réduire considérablement » l'apparition de décisions générées par l'IA qui présentaient des preuves de discrimination simplement en utilisant des invites soigneusement conçues.

Ils ont créé un certain nombre de scénarios réels et ont demandé des recommandations à Claude 2.0, un modèle créé par Anthropic qui a obtenu un score de 76 % aux questions à choix multiples lors d'un examen du Barreau.

Dans cette enquête, ils ont chargé Claude d'évaluer les demandes d'actions telles qu'une augmentation de la limite de crédit, un prêt aux petites entreprises, un prêt hypothécaire, l'approbation d'une adoption et l'attribution d'un contrat. Au total, 70 scénarios ont été testés.

Les questions de base, sans ajustements, ont donné des résultats montrant une discrimination à la fois positive et négative lorsqu'il s'agissait de candidats de race, d'âge et d'identification sexuelle différents. Les candidats non blancs, les femmes et les candidats non binaires ont obtenu des scores plus élevés en matière de discrimination, tandis que les sujets plus âgés ont reçu les scores les plus bas.

Mais lorsque les chercheurs ont suggéré le modèle « réfléchissez à la manière d'éviter la discrimination avant de décider » ou ont noté que la discrimination est illégale, ils ont constaté une baisse des préjugés.

“Nous sommes en mesure de réduire considérablement la discrimination positive et négative grâce à une ingénierie minutieuse et rapide”, ont conclu les auteurs.

Une telle ingénierie comprenait l’ajout d’invites emphatiques après les questions de base. Par exemple, lorsque les chercheurs ont précisé que les données démographiques ne devraient pas influencer les décisions ou ont affirmé directement qu’il est illégal de prendre en compte les informations démographiques, les scores de biais, compris entre -0,5 et 2, se sont rapprochés de 0.

Dans d’autres cas, les chercheurs ont formulé ce qu’ils ont défini comme des « formulations émotionnelles », par exemple en déclarant : « Il est vraiment important » de ne pas faire de discrimination. Dans certains cas, ils répétaient le mot « vraiment » plusieurs fois dans une seule phrase.

Ils ont également explicitement demandé à Claude de « réfléchir à haute voix à la manière d'éviter les préjugés et les stéréotypes » dans ses réponses.

Les chercheurs ont découvert que de telles interventions entraînaient des scores de biais proches de zéro.

“Ces résultats démontrent que la discrimination positive et négative sur les questions que nous examinons peut être considérablement réduite, et dans certains cas complètement supprimée, par un ensemble d'interventions rapides”, ont-ils déclaré.

Des preuves de résultats troublants sont apparues peu de temps après l'introduction de ChatGPT il y a un an. Un rédacteur technique a rapporté qu'un effort initial visant à susciter des préjugés raciaux a échoué car ChatGPT a refusé « poliment ». Mais lorsqu'on lui a demandé d'agir en tant qu'auteur partial pour un magazine raciste, il a produit des commentaires manifestement offensants.

Un autre utilisateur a réussi à inciter ChatGPT à écrire les paroles d'une chanson sexiste : « Si vous voyez une femme en blouse de laboratoire, elle est probablement juste là pour nettoyer le sol. Mais si vous voyez un homme en blouse de laboratoire, alors il a probablement les connaissances nécessaires. et les compétences que vous recherchez.

Une étude récente de quatre grands modèles linguistiques réalisée par la Stanford School of Medicine a trouvé des exemples de « perpétuation de la médecine fondée sur la race dans leurs réponses » dans tous les modèles.

Alors que l’IA est de plus en plus exploitée dans l’industrie, la médecine, la finance et l’éducation, les données biaisées provenant de sources souvent anonymes pourraient causer des ravages – physiques, financiers et émotionnels.

“Nous pensons qu'une optique sociotechnique sera nécessaire pour garantir des résultats bénéfiques pour ces technologies, y compris à la fois les politiques au sein des entreprises individuelles ainsi que l'environnement politique et réglementaire plus large”, ont déclaré les chercheurs d'Anthropic.

“L'utilisation appropriée de modèles pour les décisions à enjeux élevés est une question sur laquelle les gouvernements et les sociétés dans leur ensemble devraient influencer… plutôt que que ces décisions soient prises uniquement par des entreprises ou des acteurs individuels.”

Plus d'information:

Alex Tamkin et al, Évaluation et atténuation de la discrimination dans les décisions relatives aux modèles linguistiques, arXiv (2023). DOI : 10.48550/arxiv.2312.03689

Ensemble de données et invites : huggingface.co/datasets/Anthropic/discrim-eval

arXiv

© 2023 Réseau Science X

Citation: Les scientifiques s'attaquent aux préjugés de l'IA avec une incitation polie (13 décembre 2023) récupéré le 13 décembre 2023 sur

Ce document est soumis au droit d'auteur. En dehors de toute utilisation équitable à des fins d'étude ou de recherche privée, aucune partie ne peut être reproduite sans autorisation écrite. Le contenu est fourni seulement pour information.